ChatGPT, Perplexity, Claude등 여러가지 LLM모델을 사용해 프로젝트 작업, 일상에 많은 도움을 받고 있다.

다만, 외부 서버를 거치기 때문에 민감한 정보가 포함된 질문을 하기에는 깨름직한 부분이 있다.

이 문제를 해결해보고자 로컬 LLM환경을 구축해 사용하고 있었다.

관련 글 :

https://w-storage.tistory.com/53

맥북에서 LLM을 실행해보자! (Llama2, Ollama)

1. 개요 바야흐로 LLM(Large language model) 전성시대이다. 하루가 멀다하고 여러 LLM이 등장하고 있으며 이를 통해 생산성이 크게 향상되고 있다. 유명한 LLM으로는 GPT, Gemini, Claude등이 있는데, 이런 서

w-storage.tistory.com

https://w-storage.tistory.com/54

VSCode에서 Llama2를 실행해보자!

"맥북에서 LLM을 실행해보자! (Llama2, Ollama)"글의 다음편 입니다. https://w-storage.tistory.com/53 맥북에서 LLM을 실행해보자! (Llama2, Ollama) 1. 개요 바야흐로 LLM(Large language model) 전성시대이다. 하루가 멀다

w-storage.tistory.com

https://w-storage.tistory.com/69

UI환경에서 Ollama를 이용해보자 - Ollamac

개인적으로 local LLM에 관심이 있어 여러가지 상황에서 이용해보고 있다.Ollama를 이용해 LLM모델을 사용하는데, 터미널에서 질문하고 답변을 듣는것은 여러가지 불편한점이 있어 UI환경에서 Ollama

w-storage.tistory.com

이렇게 로컬 LLM을 이용하며 다른 문제를 또 겪었는데 이미지/파일첨부나 웹 검색을 통한 답변 생성 기능이 Ollamac에서는 지원하지 않는 것이다.

이 문제를 해결하기 위해 다른 방법들을 더 찾아보았다.

이번 글에서는 Open WebUI를 이용한 로컬 LLM사용 방법을 정리해 보았다.

1. Docker환경 세팅하기

Open WebUI는 Python개발 환경을 구축하는 방법과 Docker를 이용하는 방법 두 가지중 하나를 이용해 사용할 수 있다.

이 프로젝트의 목적은 로컬 LLM환경을 구축하는것이기 때문에, Docker를 이용하는것이 더 편할것 같다 판단해 Orbstack을 이용하기로 했다.

Orbstack은 mac환경에서 사용할 수 있으며, Docker desktop보다 가볍고 빠른 장점이 있다.

아래 사이트에서 Orbstack을 설치할 수 있다.

OrbStack · Fast, light, simple Docker & Linux

Say goodbye to slow, clunky containers and VMs. The fast, light, and easy way to run containers and Linux. Develop at lightspeed with our Docker Desktop alternative.

orbstack.dev

2. Open WebUI설치

Open WebUI GitHub에 설치 방법이 나와있다. 환경에 맞는 방법을 이용하면 된다.

https://github.com/open-webui/open-webui

GitHub - open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, ...)

User-friendly AI Interface (Supports Ollama, OpenAI API, ...) - open-webui/open-webui

github.com

나는 로컬에 Ollama가 설치되어있기 때문에 아래의 명령어를 사용했다.

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

이후 Orbstack에서 환경을 실행하고 localhost:3000에 접속하면 Open WebUI환경에 접속할 수 있다.

이번에는 최근 화재인 DeepSeek R1모델을 사용해보았다.

UI는 채팅 리스트, 모델 선택, 질문 등 ChatGPT와 거의 유사해서 적응은 딱히 필요가 없었고, 웹 검색이 딱히 필요 없다면 이대로 이용해도 괜찮다.

기본적으로 파일 첨부 기능을 제공하기 때문에 사용성이 더 높은것 같다.

또 우측 상단의 버튼을 통해 TopK, 배치 크기, 토큰 수 등 여러 매개변수들을 수정할 수 있었다.

3. 웹 검색 기능 켜기

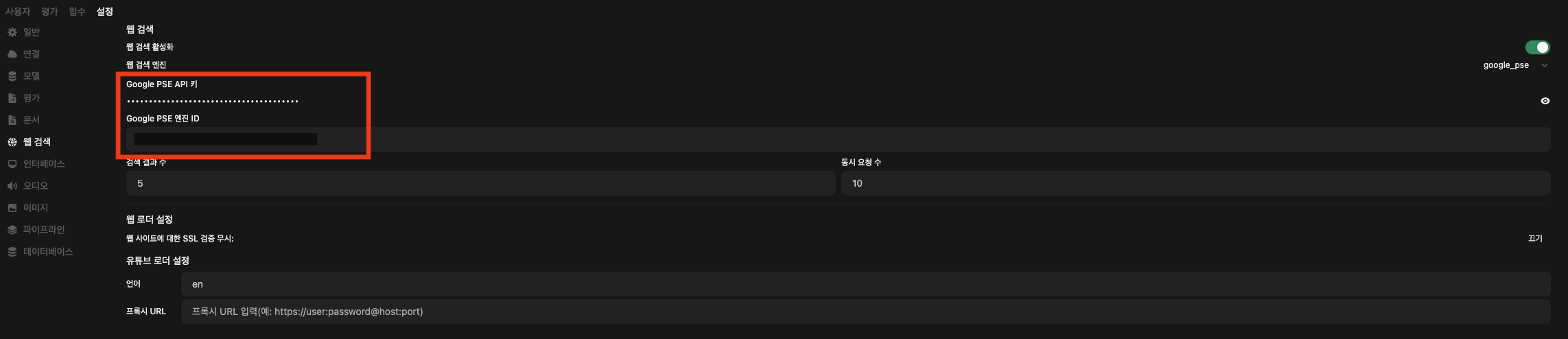

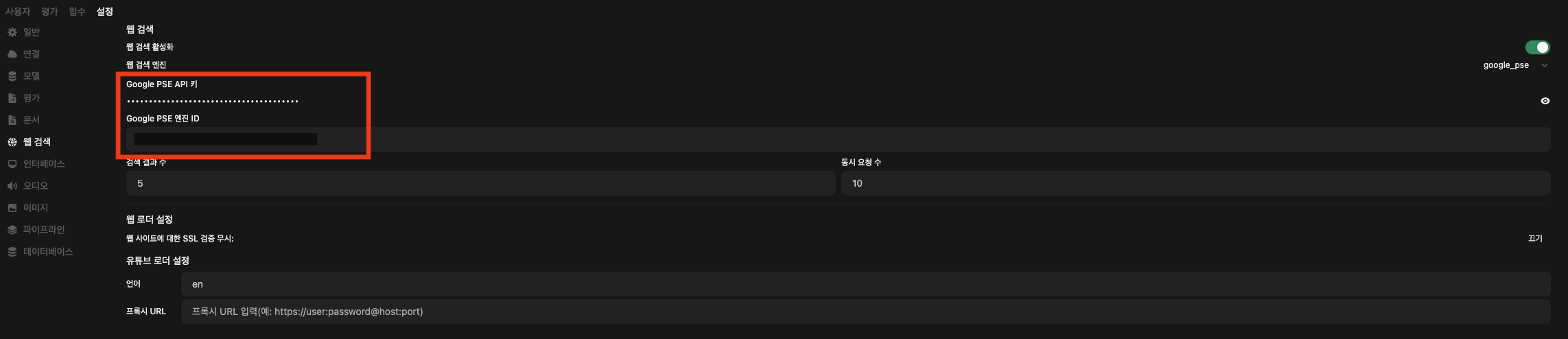

설정 > 웹 검색 > 웹 검색 활성화를 on으로 바꾸면 된다.

이후 검색 엔진을 선택하면 되는데 나는 Google을 이용하기로 했다.

Google검색 엔진을 사용하기 위해선 Google PSE API키와 Google PSE 엔진 ID를 추가해야 한다.

Google PSE API키와 엔진 ID는 아래 주소에서 발급받을 수 있다.

https://programmablesearchengine.google.com/about/

Programmable Search Engine by Google

Help people find what they need on your website. Add a customizable search box to your web pages and show fast, relevant results powered by Google.

programmablesearchengine.google.com

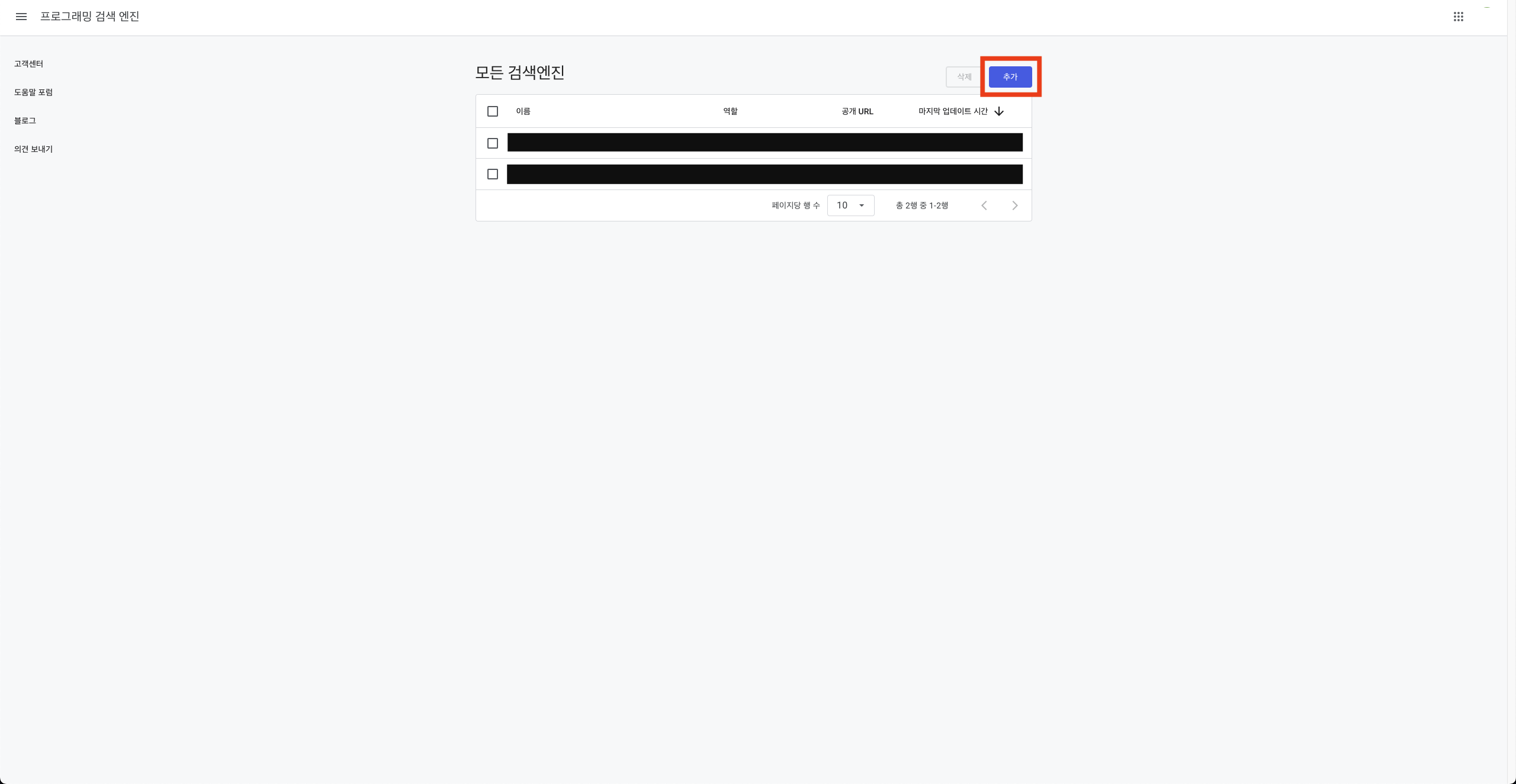

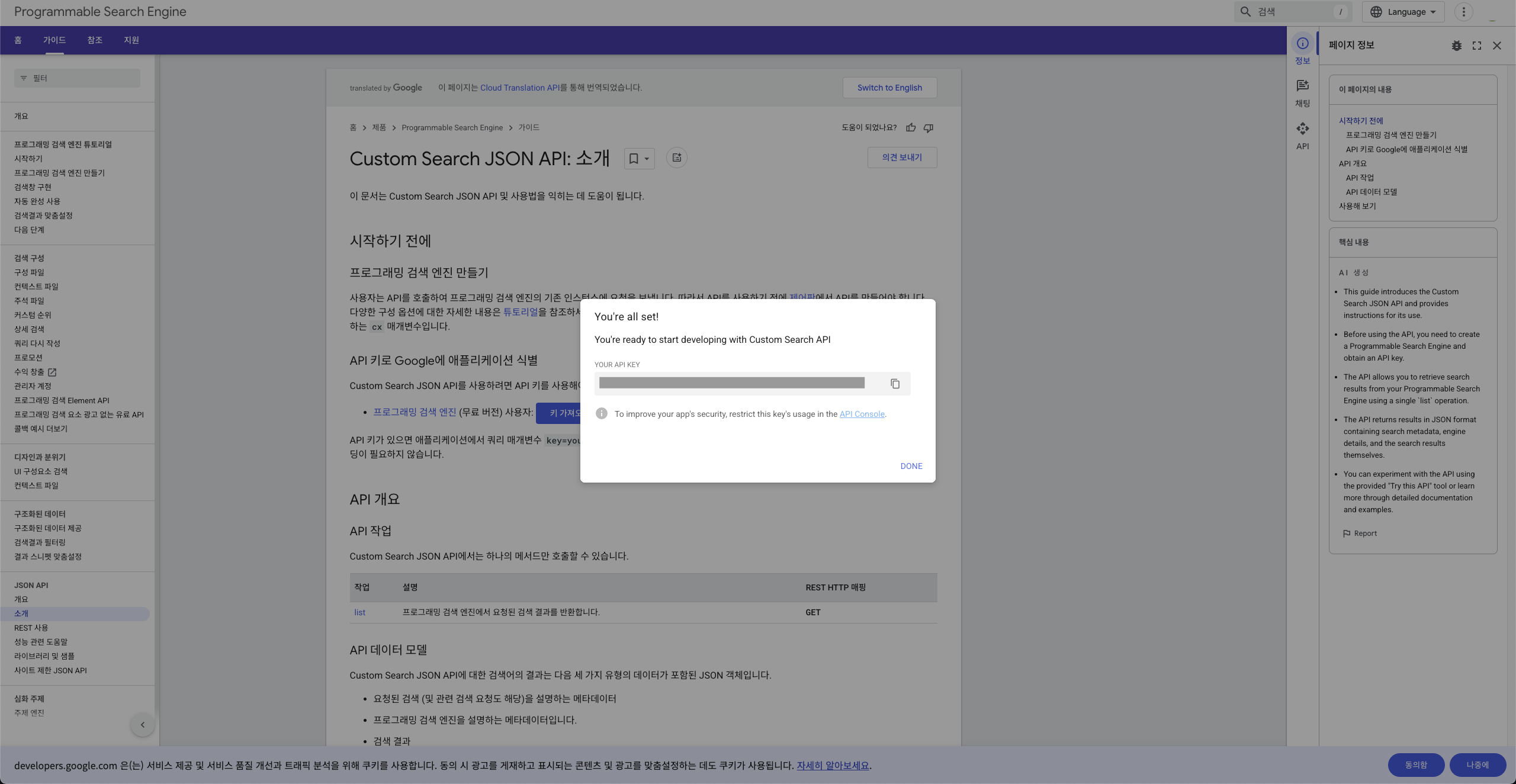

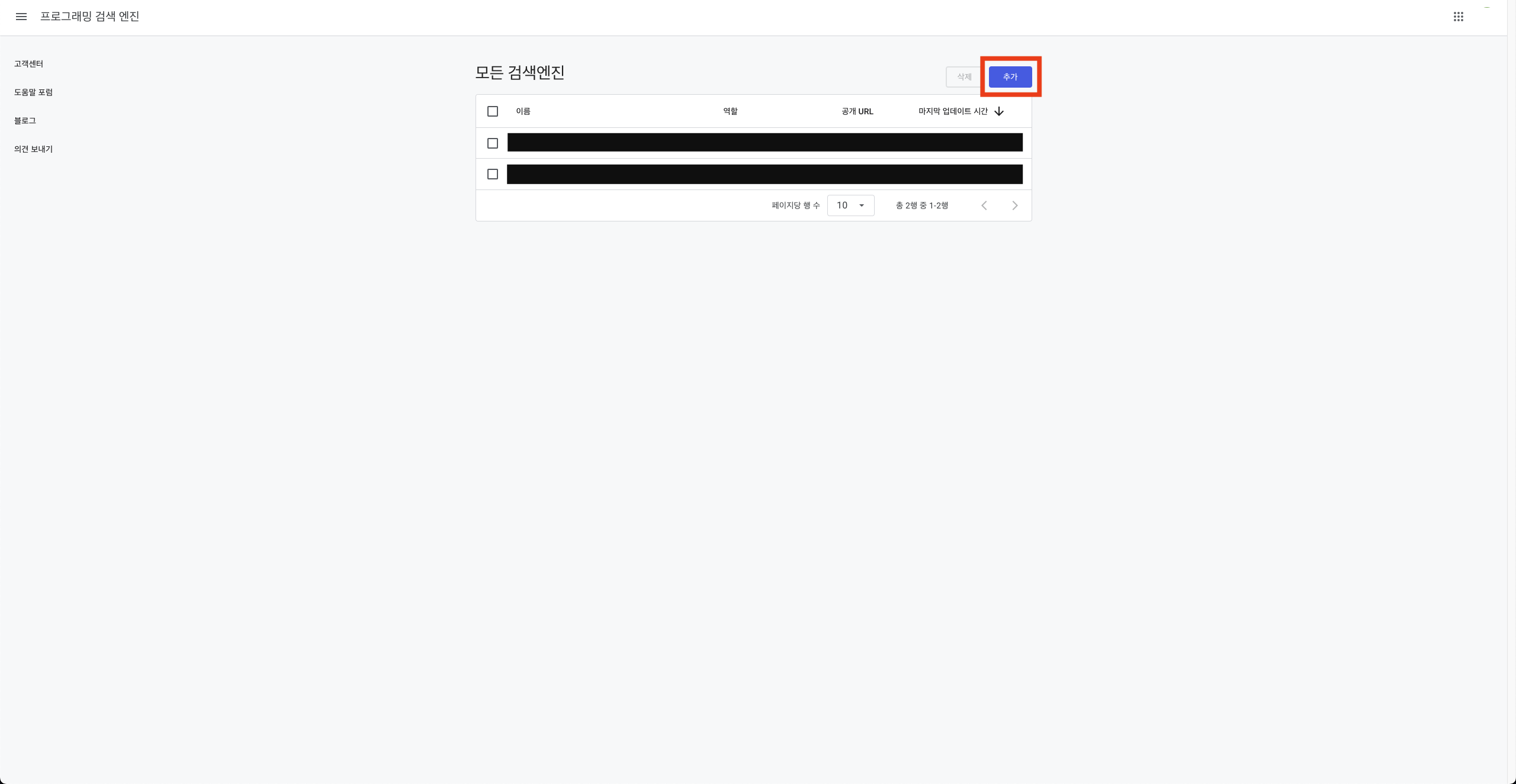

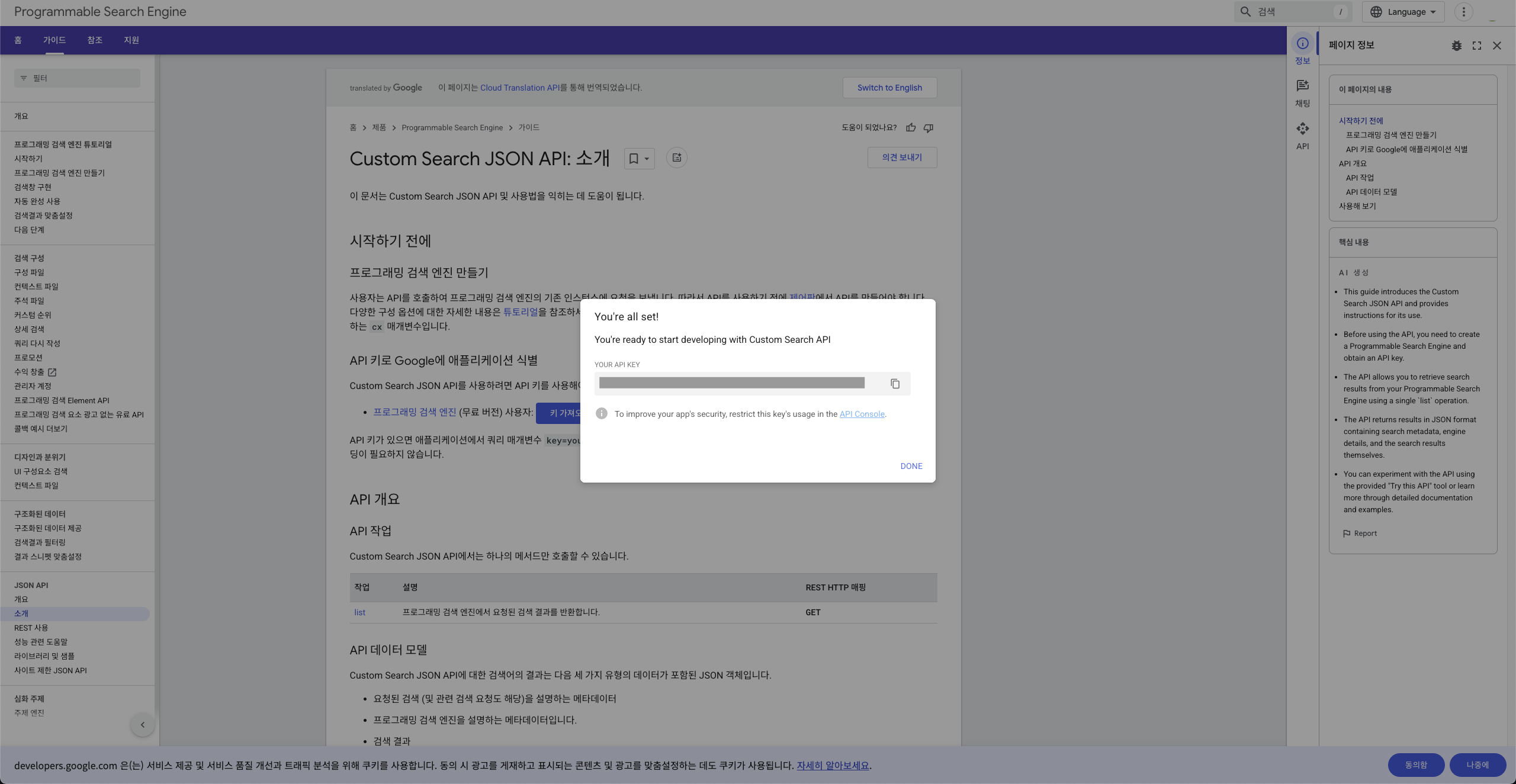

로그인 후 "추가"버튼을 누른다.

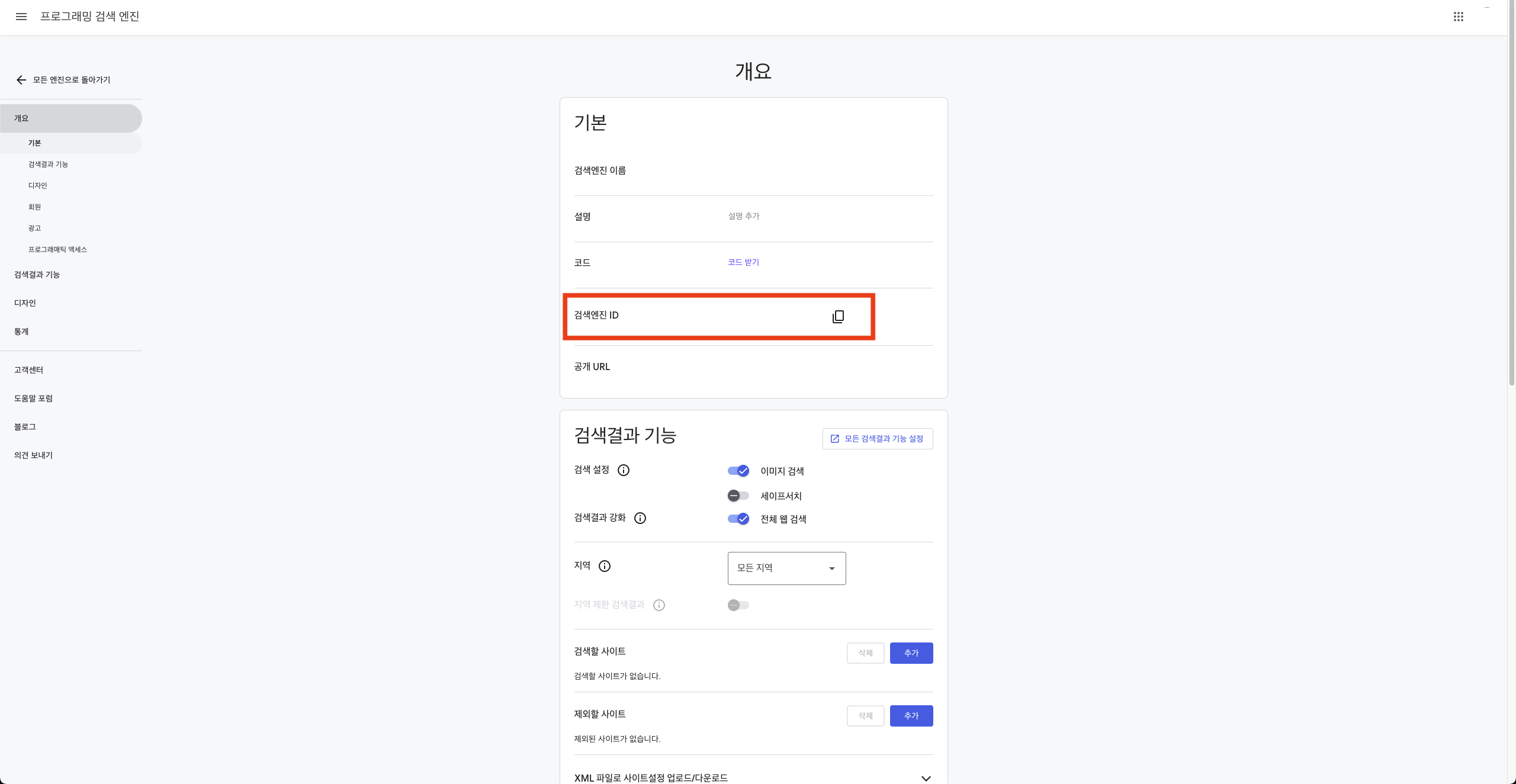

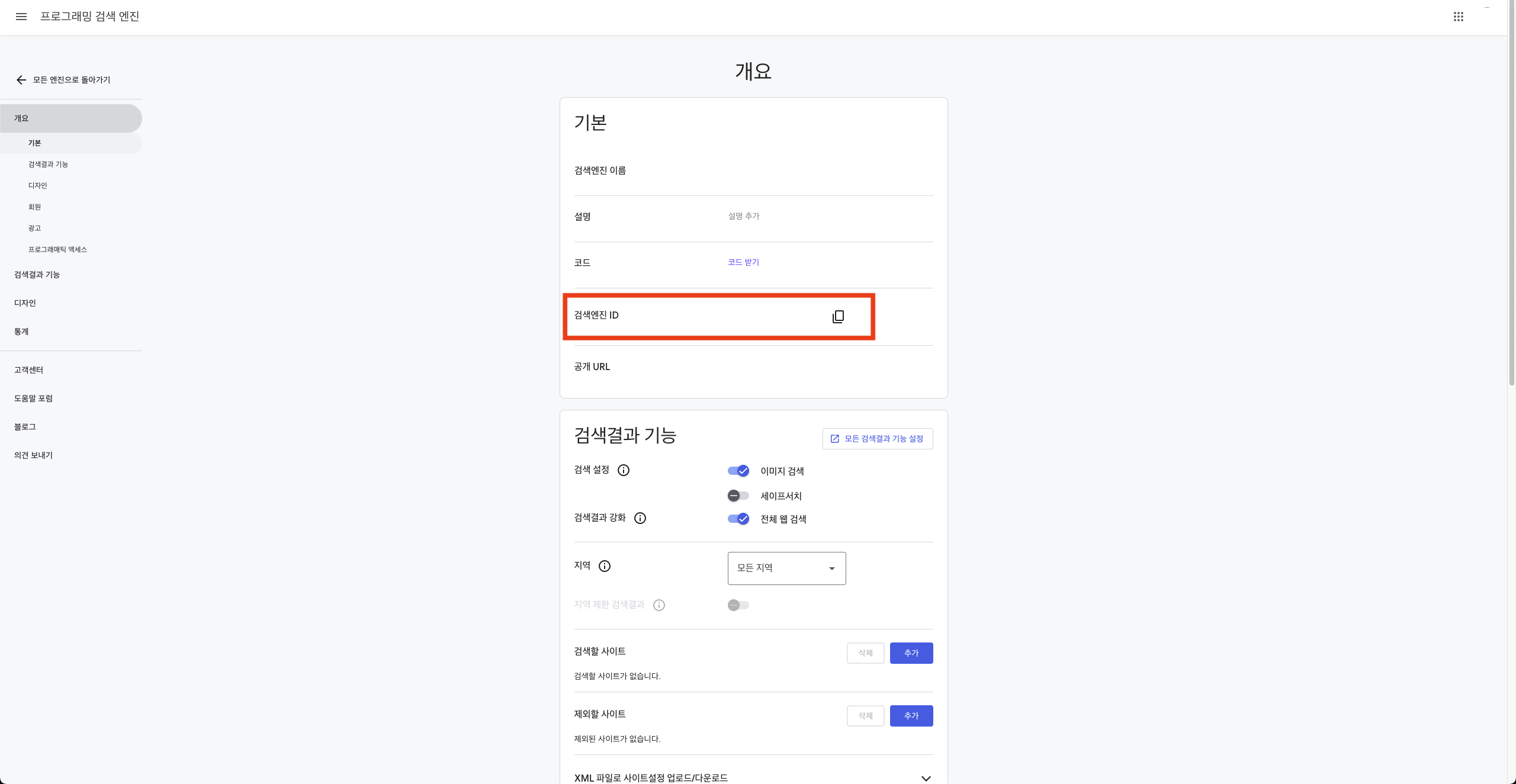

이후 엔진 이름을 지정하면 개요 화면을 볼 수 있다.

여기서 "검색엔진 ID"의 값을 "Google PSE 엔진 ID"에 넣으면 된다.

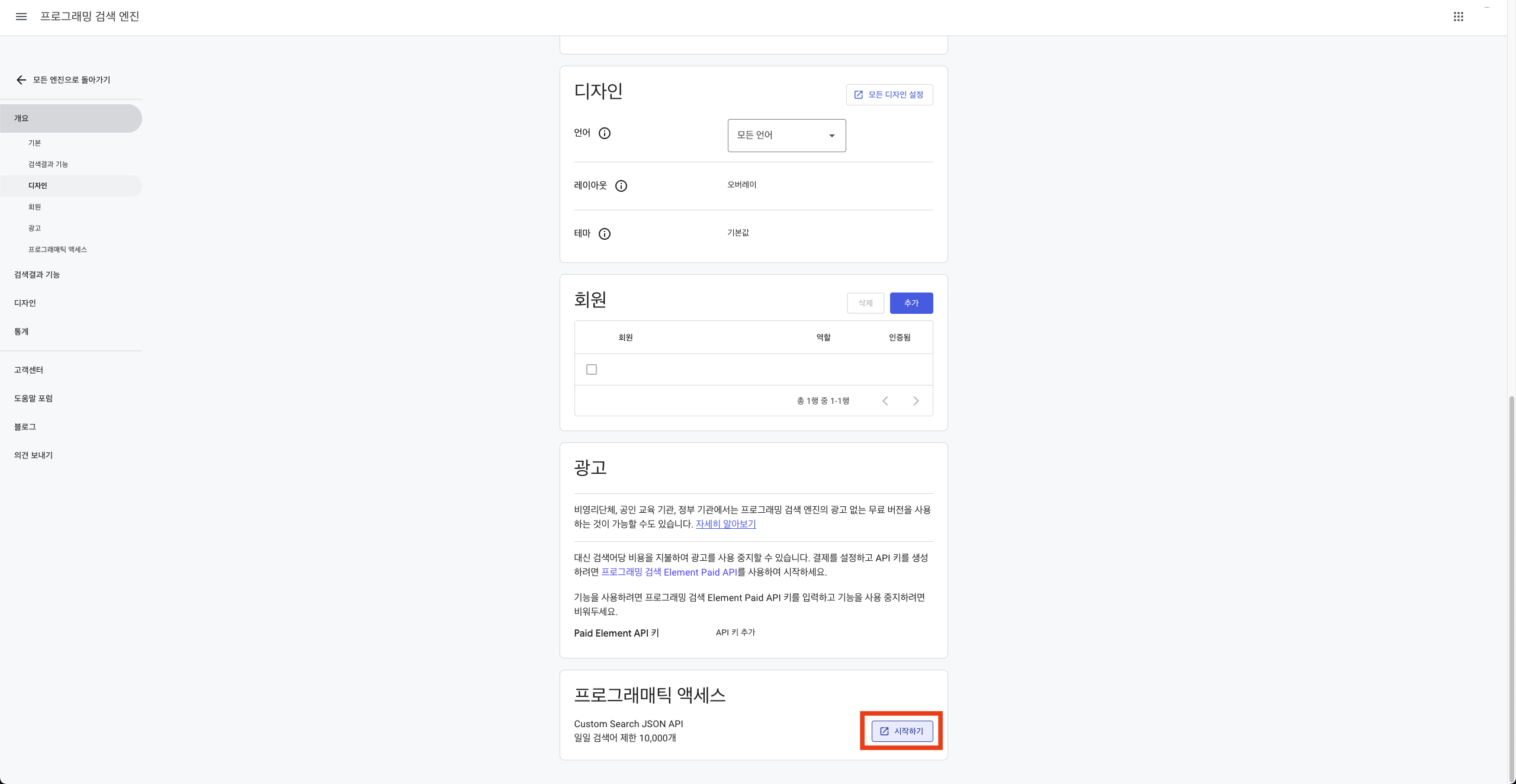

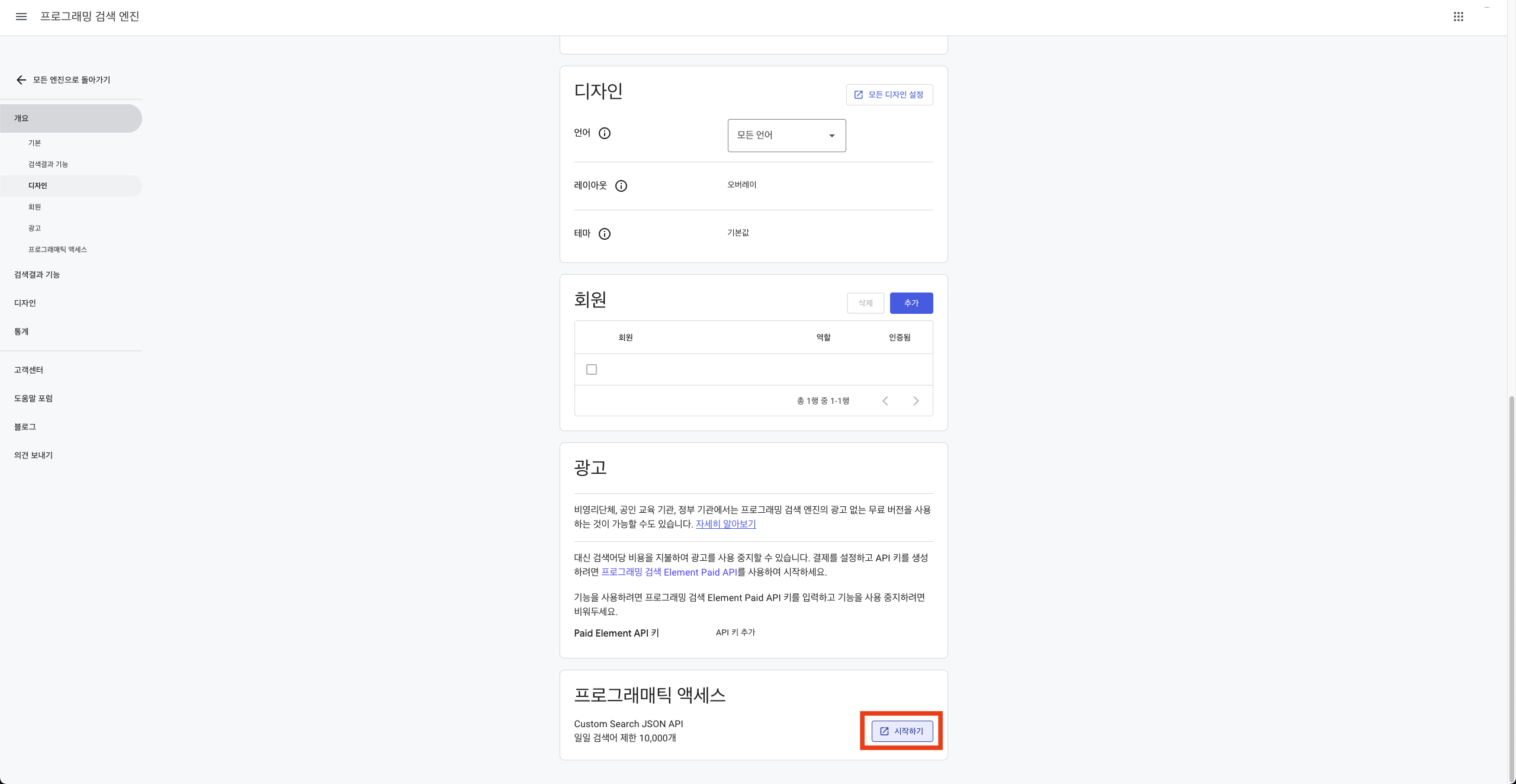

그리고 스크롤을 내리면 "프로그래매틱 액세스"항목이 있는데 "시작하기"를 누른다.

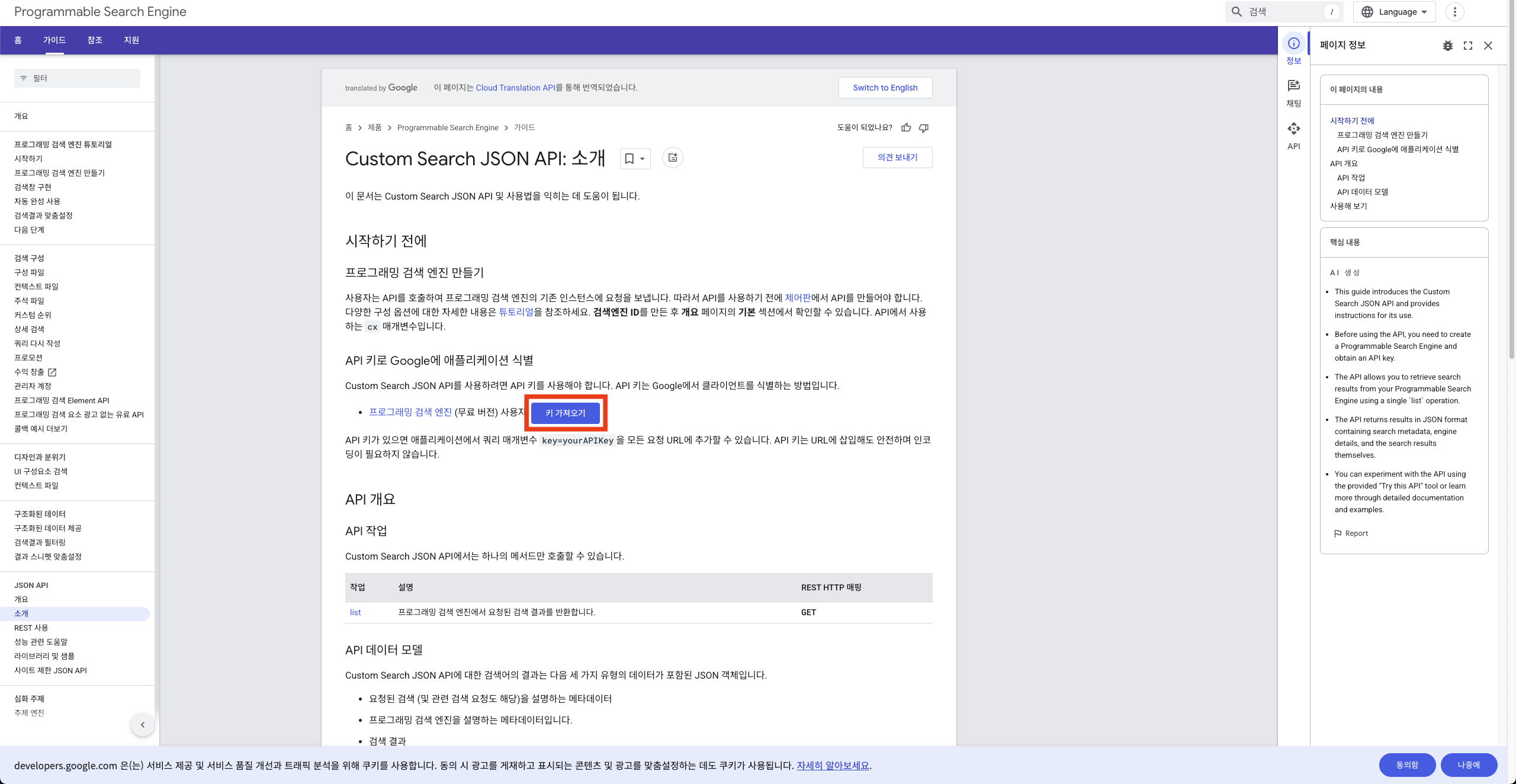

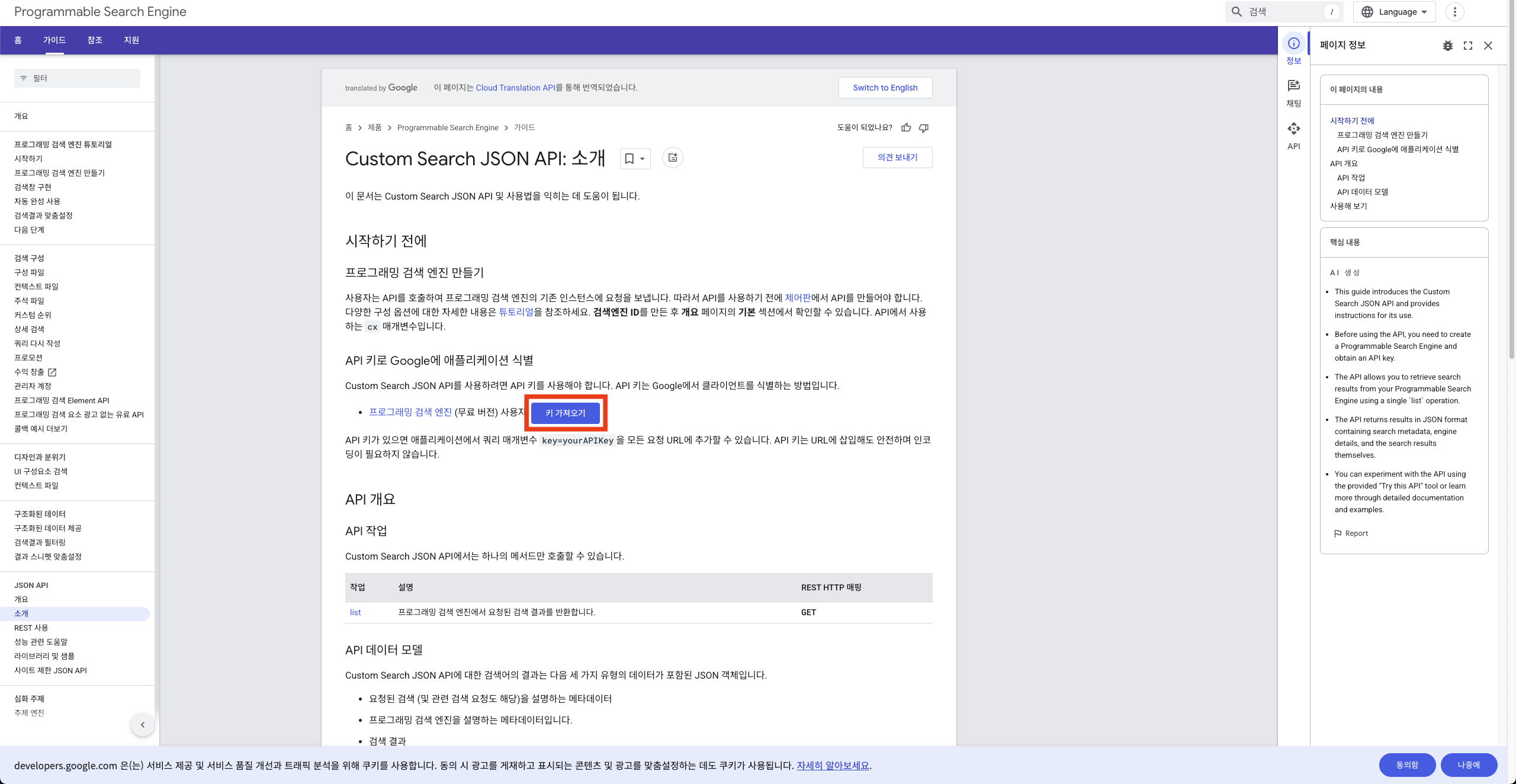

이후 "키 가져오기"버튼을 누르고 정보를 입력하면 Google PSE API키를 발급받을 수 있다.

이 키를 "Google PSE API"란에 입력하면 된다.

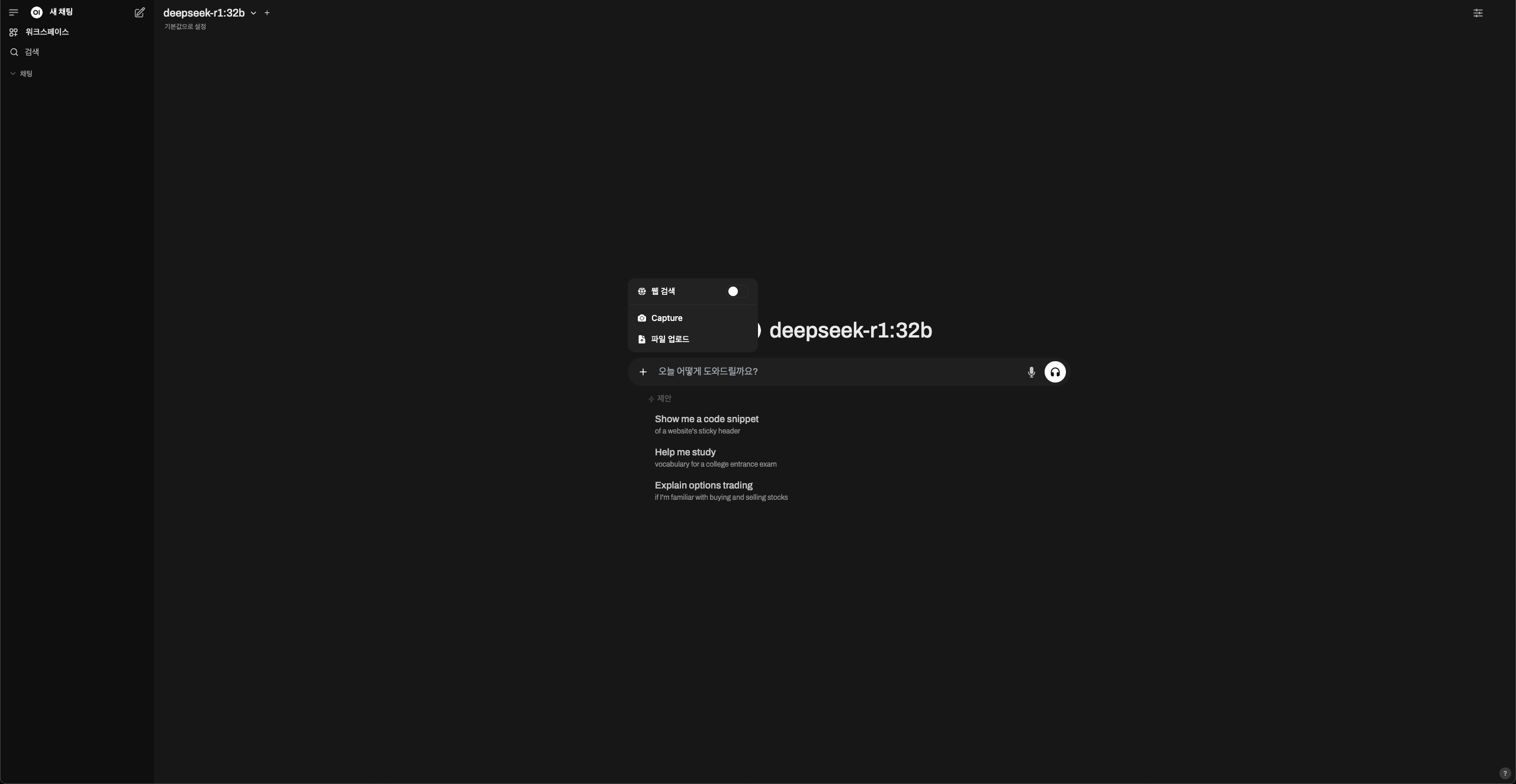

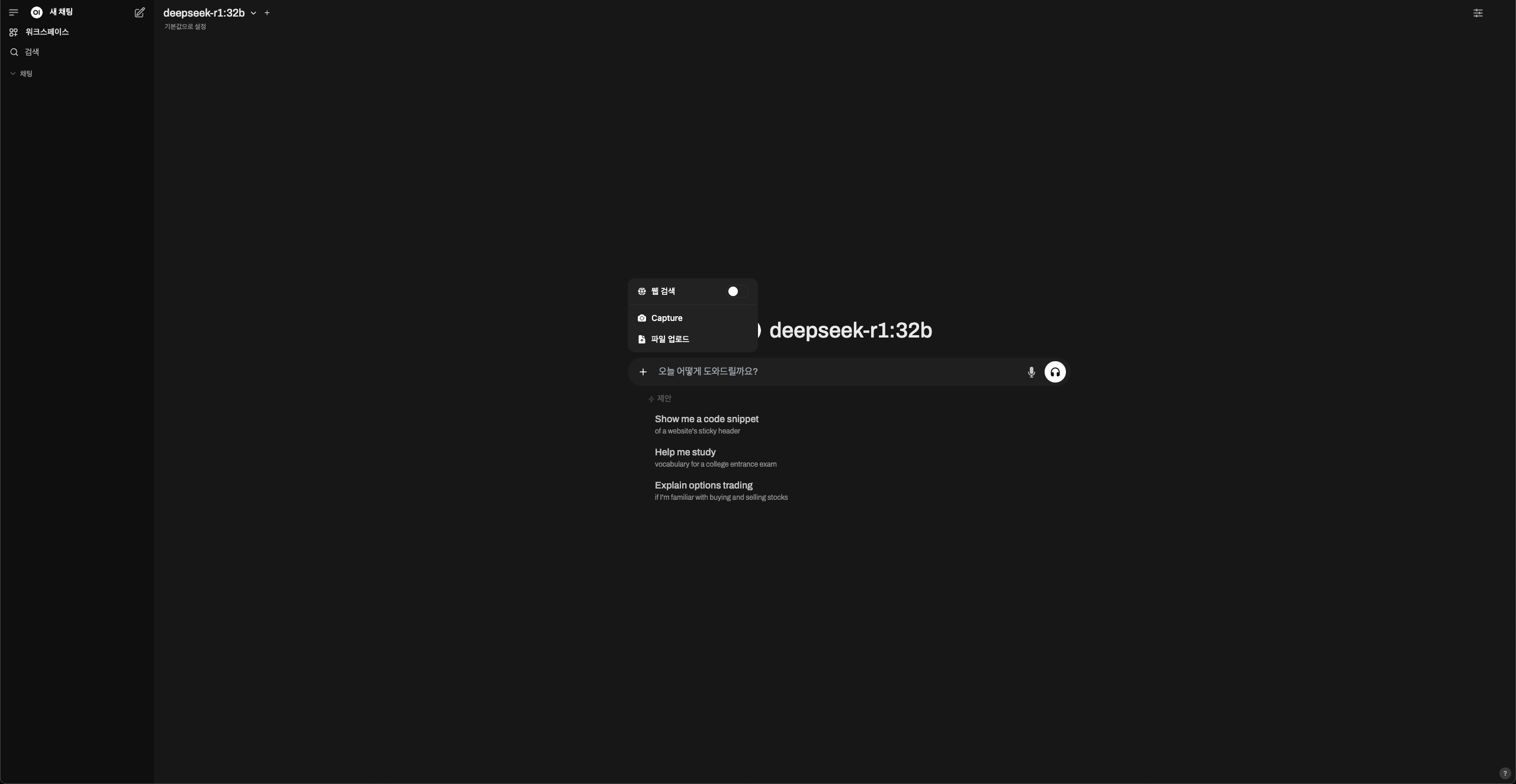

4. 웹 검색 사용하기

채팅 입력란에서 "+"버튼을 눌러보면 "웹 검색"기능이 새로 생긴것을 확인할 수 있다. 이를 on으로 바꾸면 웹 검색을 통한 답변 생성 기능을 이용할 수 있다.

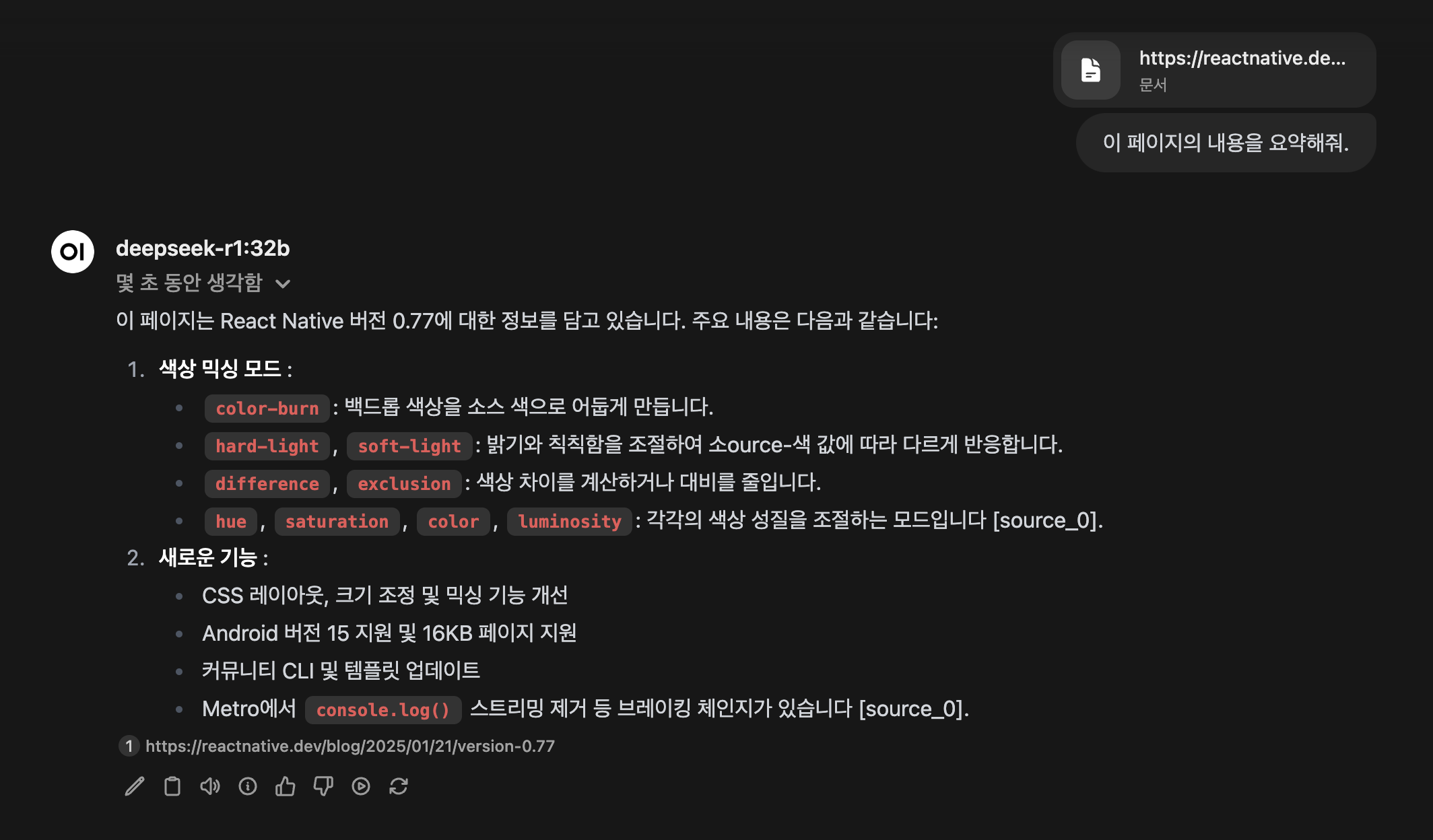

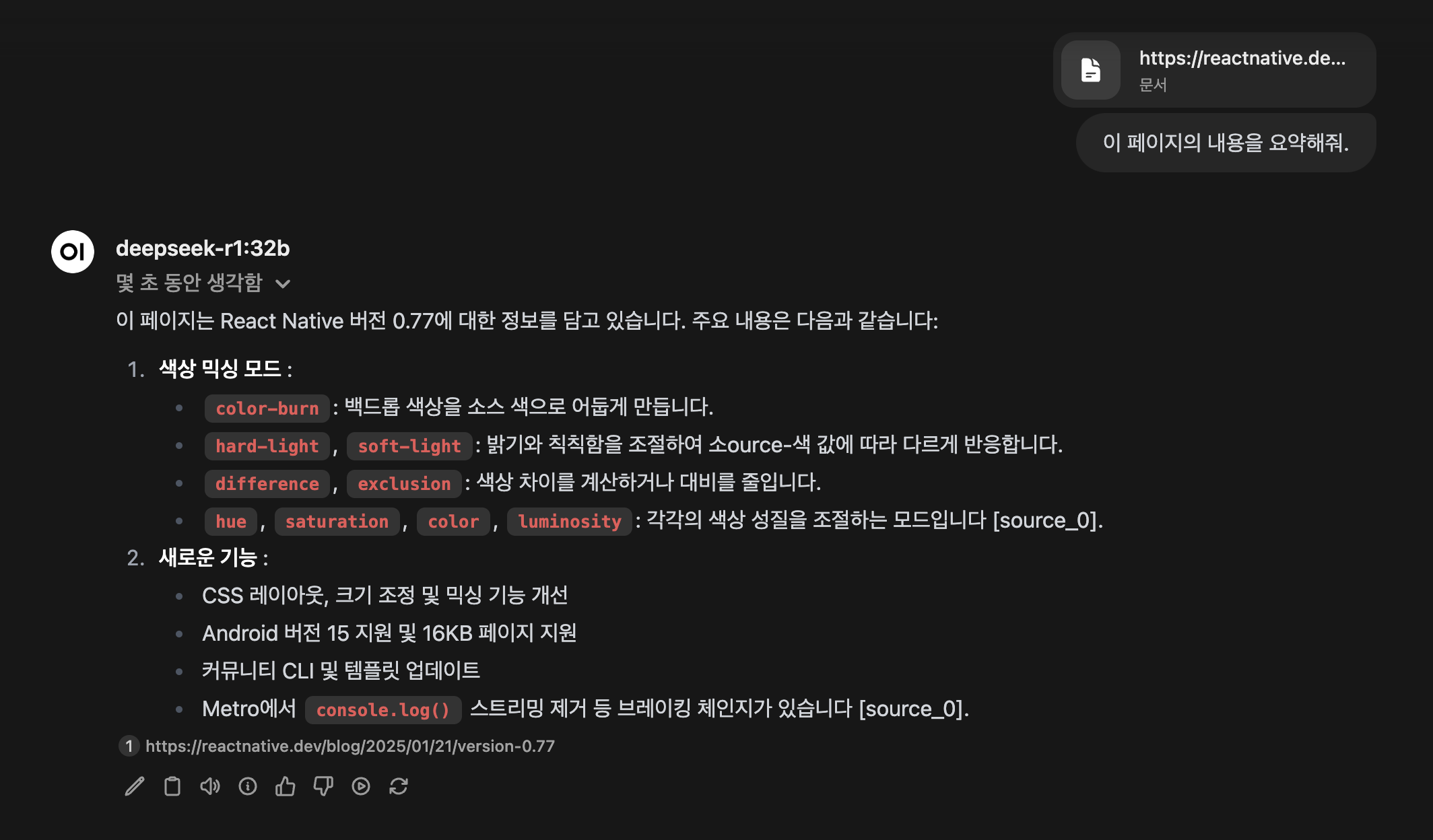

5. TIP : 웹 검색 없이 특정 사이트의 내용 찾기

아래와 같은 방식을 이용하면 특정 사이트(URL)만 참조하게 할 수 있다.

#[URL 주소]

채팅 내용이 방법을 이용해 React Native 0.77버전의 릴리즈 노트를 요약해달라 해보았다.

잘 동작하는것 같다!

'프로젝트' 카테고리의 다른 글

| UI환경에서 Ollama를 이용해보자 - Ollamac (0) | 2024.11.10 |

|---|---|

| VSCode에서 Llama2를 실행해보자! (2) | 2024.04.11 |

| 맥북에서 LLM을 실행해보자! (Llama2, Ollama) (1) | 2024.03.29 |

| [React Native] component shaker 라이브러리를 만들었다 (0) | 2024.03.08 |

| [아쿠쿠아] v1.4.0 출시! (4) | 2024.02.25 |

ChatGPT, Perplexity, Claude등 여러가지 LLM모델을 사용해 프로젝트 작업, 일상에 많은 도움을 받고 있다.

다만, 외부 서버를 거치기 때문에 민감한 정보가 포함된 질문을 하기에는 깨름직한 부분이 있다.

이 문제를 해결해보고자 로컬 LLM환경을 구축해 사용하고 있었다.

관련 글 :

https://w-storage.tistory.com/53

맥북에서 LLM을 실행해보자! (Llama2, Ollama)

1. 개요 바야흐로 LLM(Large language model) 전성시대이다. 하루가 멀다하고 여러 LLM이 등장하고 있으며 이를 통해 생산성이 크게 향상되고 있다. 유명한 LLM으로는 GPT, Gemini, Claude등이 있는데, 이런 서

w-storage.tistory.com

https://w-storage.tistory.com/54

VSCode에서 Llama2를 실행해보자!

"맥북에서 LLM을 실행해보자! (Llama2, Ollama)"글의 다음편 입니다. https://w-storage.tistory.com/53 맥북에서 LLM을 실행해보자! (Llama2, Ollama) 1. 개요 바야흐로 LLM(Large language model) 전성시대이다. 하루가 멀다

w-storage.tistory.com

https://w-storage.tistory.com/69

UI환경에서 Ollama를 이용해보자 - Ollamac

개인적으로 local LLM에 관심이 있어 여러가지 상황에서 이용해보고 있다.Ollama를 이용해 LLM모델을 사용하는데, 터미널에서 질문하고 답변을 듣는것은 여러가지 불편한점이 있어 UI환경에서 Ollama

w-storage.tistory.com

이렇게 로컬 LLM을 이용하며 다른 문제를 또 겪었는데 이미지/파일첨부나 웹 검색을 통한 답변 생성 기능이 Ollamac에서는 지원하지 않는 것이다.

이 문제를 해결하기 위해 다른 방법들을 더 찾아보았다.

이번 글에서는 Open WebUI를 이용한 로컬 LLM사용 방법을 정리해 보았다.

1. Docker환경 세팅하기

Open WebUI는 Python개발 환경을 구축하는 방법과 Docker를 이용하는 방법 두 가지중 하나를 이용해 사용할 수 있다.

이 프로젝트의 목적은 로컬 LLM환경을 구축하는것이기 때문에, Docker를 이용하는것이 더 편할것 같다 판단해 Orbstack을 이용하기로 했다.

Orbstack은 mac환경에서 사용할 수 있으며, Docker desktop보다 가볍고 빠른 장점이 있다.

아래 사이트에서 Orbstack을 설치할 수 있다.

OrbStack · Fast, light, simple Docker & Linux

Say goodbye to slow, clunky containers and VMs. The fast, light, and easy way to run containers and Linux. Develop at lightspeed with our Docker Desktop alternative.

orbstack.dev

2. Open WebUI설치

Open WebUI GitHub에 설치 방법이 나와있다. 환경에 맞는 방법을 이용하면 된다.

https://github.com/open-webui/open-webui

GitHub - open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, ...)

User-friendly AI Interface (Supports Ollama, OpenAI API, ...) - open-webui/open-webui

github.com

나는 로컬에 Ollama가 설치되어있기 때문에 아래의 명령어를 사용했다.

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

이후 Orbstack에서 환경을 실행하고 localhost:3000에 접속하면 Open WebUI환경에 접속할 수 있다.

이번에는 최근 화재인 DeepSeek R1모델을 사용해보았다.

UI는 채팅 리스트, 모델 선택, 질문 등 ChatGPT와 거의 유사해서 적응은 딱히 필요가 없었고, 웹 검색이 딱히 필요 없다면 이대로 이용해도 괜찮다.

기본적으로 파일 첨부 기능을 제공하기 때문에 사용성이 더 높은것 같다.

또 우측 상단의 버튼을 통해 TopK, 배치 크기, 토큰 수 등 여러 매개변수들을 수정할 수 있었다.

3. 웹 검색 기능 켜기

설정 > 웹 검색 > 웹 검색 활성화를 on으로 바꾸면 된다.

이후 검색 엔진을 선택하면 되는데 나는 Google을 이용하기로 했다.

Google검색 엔진을 사용하기 위해선 Google PSE API키와 Google PSE 엔진 ID를 추가해야 한다.

Google PSE API키와 엔진 ID는 아래 주소에서 발급받을 수 있다.

https://programmablesearchengine.google.com/about/

Programmable Search Engine by Google

Help people find what they need on your website. Add a customizable search box to your web pages and show fast, relevant results powered by Google.

programmablesearchengine.google.com

로그인 후 "추가"버튼을 누른다.

이후 엔진 이름을 지정하면 개요 화면을 볼 수 있다.

여기서 "검색엔진 ID"의 값을 "Google PSE 엔진 ID"에 넣으면 된다.

그리고 스크롤을 내리면 "프로그래매틱 액세스"항목이 있는데 "시작하기"를 누른다.

이후 "키 가져오기"버튼을 누르고 정보를 입력하면 Google PSE API키를 발급받을 수 있다.

이 키를 "Google PSE API"란에 입력하면 된다.

4. 웹 검색 사용하기

채팅 입력란에서 "+"버튼을 눌러보면 "웹 검색"기능이 새로 생긴것을 확인할 수 있다. 이를 on으로 바꾸면 웹 검색을 통한 답변 생성 기능을 이용할 수 있다.

5. TIP : 웹 검색 없이 특정 사이트의 내용 찾기

아래와 같은 방식을 이용하면 특정 사이트(URL)만 참조하게 할 수 있다.

#[URL 주소]

채팅 내용이 방법을 이용해 React Native 0.77버전의 릴리즈 노트를 요약해달라 해보았다.

잘 동작하는것 같다!

'프로젝트' 카테고리의 다른 글

| UI환경에서 Ollama를 이용해보자 - Ollamac (0) | 2024.11.10 |

|---|---|

| VSCode에서 Llama2를 실행해보자! (2) | 2024.04.11 |

| 맥북에서 LLM을 실행해보자! (Llama2, Ollama) (1) | 2024.03.29 |

| [React Native] component shaker 라이브러리를 만들었다 (0) | 2024.03.08 |

| [아쿠쿠아] v1.4.0 출시! (4) | 2024.02.25 |